Serverless в 2025: Как AWS Lambda и Edge Computing Снижают Затраты на 70%

29.10.2025

Serverless архитектура

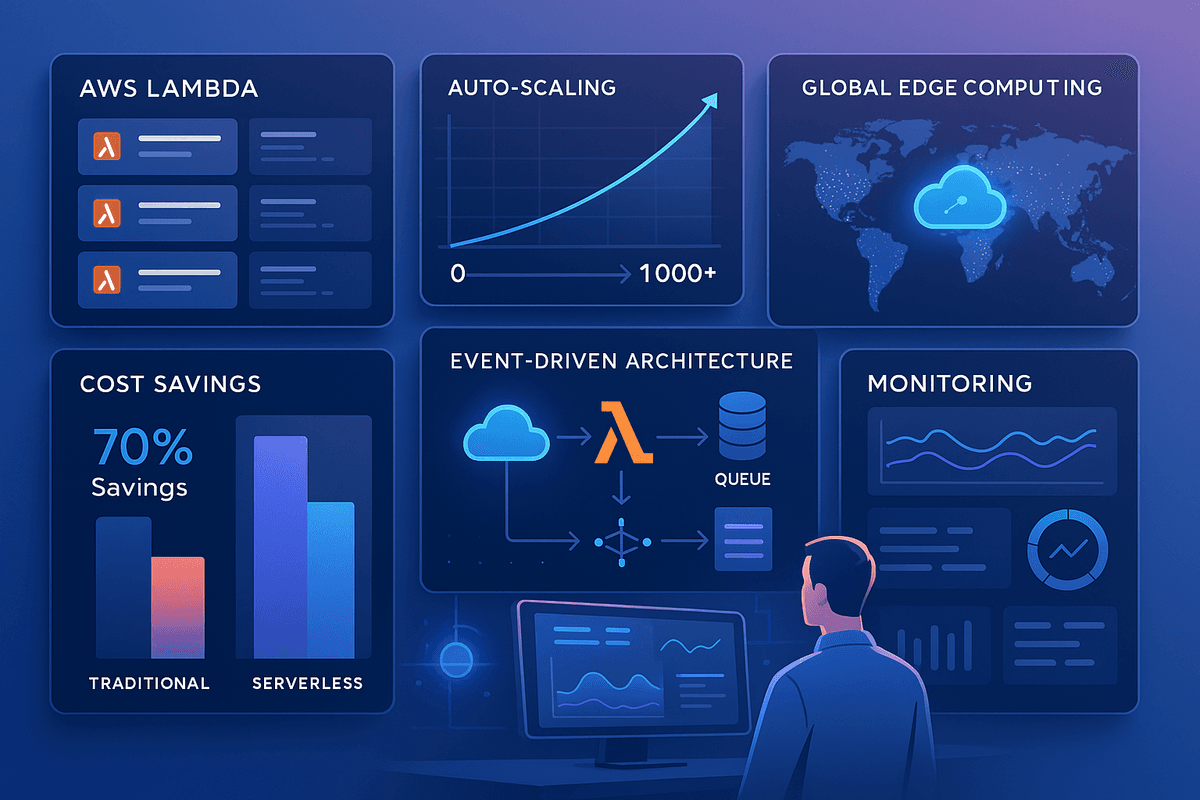

Serverless архитектура революционизирует backend разработку в 2025 году. Рынок serverless достигнет $17.78 млрд, и разработчики массово переходят на AWS Lambda, Google Cloud Functions и Cloudflare Workers. Главное преимущество — платите только за фактическое использование, без управления серверами. Serverless автоматически масштабируется под нагрузку, снижает операционные затраты на 60-70%, и позволяет разработчикам фокусироваться на бизнес-логике вместо инфраструктуры. Edge computing приближает вычисления к пользователям, уменьшая latency до минимума. Компании типа Netflix, Airbnb, и Coca-Cola используют serverless для обработки миллионов событий в секунду.

Высокие затраты на содержание серверов

Выделенные серверы работают 24/7, даже когда приложение простаивает (ночью, выходные, low traffic периоды). Вы платите за полный capacity, даже если используется 10%. Масштабирование требует покупки новых серверов за месяцы до пика нагрузки. Утром может быть 100% нагрузка, вечером 5%, но вы платите за 100% постоянно. Это ведёт к перерасходам $1000-10000+ в месяц для среднего приложения.

Решение проблемы: Serverless — оплата только за execution time (обычно за миллион запросов или за 100 ms использования). Если приложение простаивает 10 часов в сутки, вы платите только за 14 часов. Автоматическое масштабирование от 0 до 1000+ инстансов при пиках нагрузки. Типично, компании экономят 60-70% на инфраструктуре. AWS Lambda стоит $0.20 за миллион запросов + $0.0000166667 за GB-second. Для low-to-medium трафика часто получается дешевле, чем выделенный сервер.

Сложное управление инфраструктурой

Настройка, обслуживание, мониторинг серверов отнимает время. Нужно следить за uptime, обновлениями ОС, security patches, дисковым пространством. DevOps команда тратит 30-40% времени на maintenance вместо новых фич. Когда случается incident, нужно срочно чинить инфраструктуру вместо того, чтобы фокусироваться на бизнесе. Это создаёт bottleneck для стартапов без полноценной DevOps команды.

Решение проблемы: Cloud провайдеры (AWS, Google, Azure, Cloudflare) полностью управляют инфраструктурой — вы пишете только код. Никакого maintenance, patching, uptime забот. Фокус 100% на бизнес-логике. Масштабирование происходит автоматически. Monitoring и logging интегрированы в платформу. Вы платите за использованные ресурсы, а не за инфраструктуру. Это идеально для стартапов, которые хотят быстро запустить и scale без инженеров в штате.

Медленное масштабирование при пиках нагрузки

При неожиданном пике трафика (viral post, sale, press coverage) традиционные серверы не успевают масштабироваться. Provisioning нового сервера может занять 10-30 минут. За это время приложение может упасть или отреагировать медленно, пользователи уходят, бизнес теряет деньги. Black Friday или запуск нового продукта — это ужас для DevOps инженеров, которые должны предугадать нагрузку за месяцы до события.

Решение проблемы: Serverless масштабируется мгновенно — от 0 до 1000+ инстансов за миллисекунды. Нет provisioning time, нет задержек. На пик нагрузки функции автоматически дублируются, обрабатывая параллельные запросы. После пика — автоматическое down-scaling, и вы платите меньше. Это позволяет confident scale приложение без страха перед отказом при внезапных всплесках трафика.

Высокая latency для глобально распределённых пользователей

Централизованный сервер в одном регионе (например, us-west-2) означает, что пользователи в Азии или Европе испытывают high latency (200-500ms). Это замедляет приложение, ухудшает UX, влияет на SEO. Для глобального scale нужно развертывать серверы в каждом регионе, что увеличивает complexity и затраты.

Решение проблемы: Edge computing (Cloudflare Workers, AWS Lambda@Edge, Vercel Edge Functions) выполняет code на edge nodes в 200+ локациях по всему миру. Запрос обрабатывается в ближайшей к пользователю локации — latency падает с 200-500ms до 10-50ms. Это невозможно с традиционными серверами без огромных затрат. Edge functions автоматически кэшируют результаты и обслуживают контент из ближайшей локации.

- Оптимизируйте cold start для быстрого первого запуска: Cold start — задержка при первом запуске неактивной функции (обычно 200-1000ms для Lambda). Это происходит, когда функция не вызывалась несколько минут и был выгружен инстанс. Минимизируйте размер функции (меньше зависимостей), используйте языки с быстрым холодным стартом (Go, Node.js лучше чем Java, Python). Используйте warm-up стратегию: CloudWatch Rules может вызывать функцию каждые 5 минут, чтобы она не холодела. Для критичных функций используйте provisioned concurrency в AWS Lambda.

- Используйте Event-Driven архитектуру для асинхронной обработки: Serverless идеален для event-driven архитектуры. Вместо polling или cron jobs, функции триггерятся событиями: S3 upload, database change, API call, queue message. Функции обрабатывают события асинхронно без блокировки. AWS EventBridge, Pub/Sub системы (RabbitMQ, Kafka) могут триггерить Lambda functions. Это масштабирует лучше и дешевле чем polling тысячи раз в секунду.

- Мониторьте затраты и используйте Reserved Concurrency для predictable pricing: Serverless может быть дешевым или дорогим в зависимости от использования. AWS Cost Explorer показывает breakdown затрат. Reserved Concurrency гарантирует minimum инстансов, что может быть дешевле при predictable нагрузке. Используйте cost alerts для предупреждения о unexpected всплесках. Optimизируйте функции: fewer invocations, меньше execution time, меньше memory. На AWS каждый GB-second дорог, оптимизируйте память (trade-off: меньше памяти = дольше execution).

- Внедрите Infrastructure as Code (IaC) для управления ресурсами: Используйте Terraform, CloudFormation, или SAM (Serverless Application Model) для определения инфраструктуры как кода. Это позволяет version control infrastructure, автоматически deploying, и disaster recovery. IaC делает easy шаг к новому окружению (staging, production) с одной командой. Это best practice в 2025 году для любого cloud приложения.

FAQ

Что такое serverless?

Модель вычислений, где cloud провайдер (AWS, Google, Azure, Cloudflare) управляет всей инфраструктурой, а вы пишете только функции (code). Вы не видите и не управляете серверами. Функции автоматически масштабируются, вы платите только за фактическое использование. Это контрастирует с IaaS (Infrastructure as a Service), где вы управляете виртуальными машинами, хотя бы немного.

Сколько экономит serverless?

60-70% на инфраструктуре по сравнению с выделенными серверами, особенно для приложений с переменной нагрузкой. Для 24/7 high-traffic приложений может быть дороже. Например, для API с 10 млн запросов/месяц: выделенный сервер $100-300/мес, Lambda $20-50/мес. Но для always-on high-traffic сайта (1 млрд+ запросов) может быть дороже. Важно правильно оценить ваш юз-кейс.

Что такое cold start?

Задержка (обычно 200-1000ms) при первом запуске неактивной функции Lambda. Это происходит, когда функция не вызывалась несколько минут. Причина: контейнер с runtime и кодом выгружается, при следующем вызове нужно загрузить и инициализировать всё снова. Провайдеры постоянно оптимизируют cold start, но он остаётся трендом. Для time-sensitive операций используйте provisioned concurrency или warm-up.

Подходит ли serverless для всех проектов?

Нет. Идеален для: API, микросервисы, обработка событий, cron jobs, webhooks. Не подходит для: long-running tasks (>15 min timeout на Lambda), always-on приложения (web server), работа с большим количеством памяти, сложные stateful операции. Для web сервера static content с Next.js на Vercel/Netlify — yes, это serverless. Для traditional web server — может быть и не рекомендуется.

Как функции общаются между собой?

Через асинхронные каналы: REST API вызовы, message queues (SQS, RabbitMQ, Kafka), pub/sub системы (EventBridge, Pub/Sub), databases, cache (Redis). Прямые сетевые соединения между функциями ненадёжны. Используйте message queues для надёжности и retry logic. Это decouples функции и делает систему more resilient.

Как хранить данные в serverless?

Используйте managed databases: DynamoDB, Firestore, MongoDB Atlas для NoSQL, Aurora RDS, Google Cloud SQL для SQL. Или cloud storage: S3, Google Cloud Storage, Azure Blob Storage для файлов. Не рекомендуется хранить state в самой функции (это уходит при завершении). Для сессии используйте Redis/Memcached. Для долгосрочных данных используйте databases. Managed services — best practice, т.к. они автоматически масштабируются.

Какие provider выбрать: AWS, Google, Azure, Cloudflare?

AWS Lambda — самый популярный и mature, экосистема огромная, но complexity высокая. Google Cloud Functions — простой и интегрирован с Google сервисами, хорош для data processing. Azure Functions — хорош если уже используете Microsoft stack. Cloudflare Workers — лучший для edge computing и глобального распределения, простой pricing. Для стартапа: Cloudflare Workers или Google Cloud Functions. Для enterprise: AWS Lambda. Для монолита: Vercel/Netlify (Next.js).