Serverless у 2025: Як AWS Lambda та Edge Computing Знижують Витрати на 70%

29.10.2025

Serverless архітектура

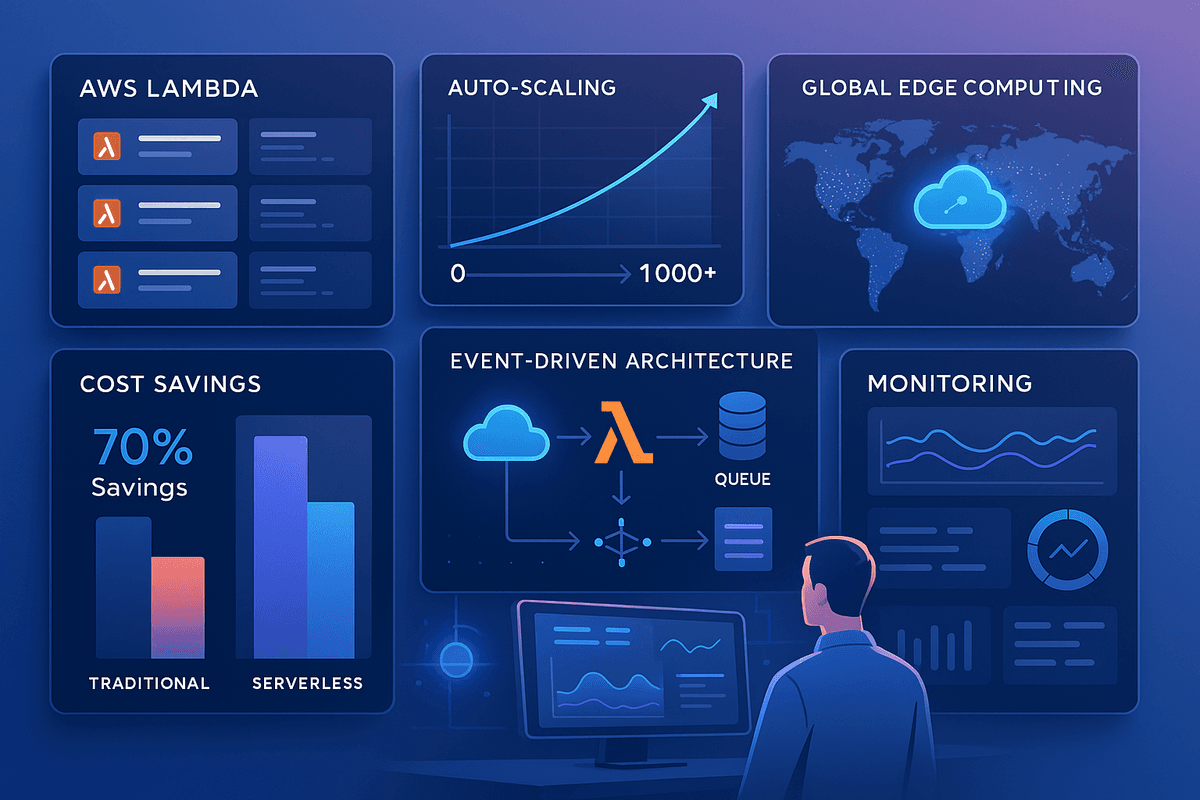

Serverless архітектура революціонізує backend розробку у 2025 році. Ринок serverless досягне $17.78 млрд, і розробники масово переходять на AWS Lambda, Google Cloud Functions та Cloudflare Workers. Головна перевага — ви платите тільки за фактичне використання, без управління серверами. Serverless автоматично масштабується під навантаження, знижує операційні витрати на 60-70%, та дозволяє розробникам сфокусуватися на бізнес-логіці замість інфраструктури. Edge computing наближає обчислення до користувачів, зменшуючи latency до мінімуму. Компанії типу Netflix, Airbnb та Coca-Cola використовують serverless для обробки мільйонів подій на секунду.

Високі витрати на утримання серверів

Виділені сервери працюють 24/7, навіть коли додаток простоює (вночі, вихідні, періоди низького трафіку). Ви платите за повну ємність, навіть якщо використовується 10%. Масштабування вимагає покупки нових серверів за місяці до пику навантаження. Вранці може бути 100% навантаження, ввечері 5%, але ви платите за 100% постійно. Це призводить до перевищення видатків $1000-10000+ на місяць для середньостатистичного додатка.

Рішення проблеми: Serverless — оплата тільки за execution time (зазвичай за мільйон запитів або за 100 ms використання). Якщо додаток простоює 10 годин на день, ви платите тільки за 14 годин. Автоматичне масштабування від 0 до 1000+ інстансів при піках навантаження. Типово, компанії економлять 60-70% на інфраструктурі. AWS Lambda коштує $0.20 за мільйон запитів + $0.0000166667 за GB-second. Для low-to-medium трафіку часто виходить дешевше, ніж виділений сервер.

Складне управління інфраструктурою

Налаштування, обслуговування, моніторинг серверів забирає час. Потрібно стежити за uptime, оновленнями ОС, security patches, дисковим простором. DevOps команда витрачає 30-40% часу на maintenance замість нових фіч. Коли трапляється incident, потрібно терміново чинити інфраструктуру замість фокусування на бізнесі. Це створює bottleneck для стартапів без повноцінної DevOps команди.

Рішення проблеми: Cloud провайдери (AWS, Google, Azure, Cloudflare) повністю управляють інфраструктурою — ви пишете тільки код. Ніякого maintenance, patching, uptime турбот. Фокус 100% на бізнес-логіці. Масштабування відбувається автоматично. Monitoring та logging інтегровані у платформу. Ви платите за використані ресурси, а не за інфраструктуру. Це ідеально для стартапів, які хочуть швидко запустити та scale без інженерів у штаті.

Повільне масштабування при піках навантаження

При неочікуваному піку трафіку (viral post, sale, press coverage) традиційні сервери не встигають масштабуватися. Provisioning нового сервера може займати 10-30 хвилин. За цей час додаток може упасти або реагувати повільно, користувачі йдуть, бізнес втрачає гроші. Black Friday або запуск нового продукту — це кошмар для DevOps інженерів, які повинні передбачити навантаження за місяці до подіï.

Рішення проблеми: Serverless масштабується миттєво — від 0 до 1000+ інстансів за мілісекунди. Немає provisioning time, немає затримок. На пік навантаження функції автоматично дублюються, обробляючи паралельні запити. Після піку — автоматичне down-scaling, і ви платите менше. Це дозволяє впевнено масштабувати додаток без страху перед відмовою при раптових всплесках трафіку.

Висока latency для глобально розподілених користувачів

Централізований сервер в одному регіоні (наприклад, us-west-2) означає, що користувачі в Азії чи Європі відчувають high latency (200-500ms). Це сповільнює додаток, погіршує UX, впливає на SEO. Для глобального scale потрібно розгортати сервери в кожному регіоні, що збільшує складність та витрати.

Рішення проблеми: Edge computing (Cloudflare Workers, AWS Lambda@Edge, Vercel Edge Functions) виконує code на edge nodes у 200+ локаціях по всьому світу. Запит обробляється в найближчій до користувача локації — latency падає з 200-500ms до 10-50ms. Це неможливо з традиційними серверами без величезних витрат. Edge functions автоматично кешують результати та обслуговують контент з найближчої локації.

- Оптимізуйте cold start для швидкого першого запуску: Cold start — затримка при першому запуску неактивної функції (зазвичай 200-1000ms для Lambda). Це трапляється, коли функція не викликалася кілька хвилин та був вивантажений інстанс. Мініміізуйте розмір функції (менше залежностей), використовуйте мови з швидким холодним стартом (Go, Node.js краще ніж Java, Python). Використовуйте warm-up стратегію: CloudWatch Rules може викликати функцію кожні 5 хвилин, щоб вона не холодила. Для критичних функцій використовуйте provisioned concurrency в AWS Lambda.

- Використовуйте Event-Driven архітектуру для асинхронної обробки: Serverless ідеальний для event-driven архітектури. Замість polling або cron jobs, функції триггеряться подіями: S3 upload, database change, API call, queue message. Функції обробляють події асинхронно без блокування. AWS EventBridge, Pub/Sub системи (RabbitMQ, Kafka) можуть триггерити Lambda functions. Це масштабує краще та дешевше ніж polling тисячі разів на секунду.

- Моніторте витрати та використовуйте Reserved Concurrency для передбачуваного ціноутворення: Serverless може бути дешевим або дорогим залежно від використання. AWS Cost Explorer показує breakdown витрат. Reserved Concurrency гарантує minimum інстансів, що може бути дешевше при передбачуваному навантаженні. Використовуйте cost alerts для попередження про unexpected всплески. Оптимізуйте функції: fewer invocations, менше execution time, менше memory. На AWS кожен GB-second дорогий, оптимізуйте пам'ять (trade-off: менше пам'яті = довше execution).

- Впровадьте Infrastructure as Code (IaC) для управління ресурсами: Використовуйте Terraform, CloudFormation, або SAM (Serverless Application Model) для визначення інфраструктури як коду. Це дозволяє version control інфраструктури, автоматично deploying, та disaster recovery. IaC робить easy крок до нового окруження (staging, production) з однією командою. Це best practice у 2025 році для будь-якого cloud додатка.

FAQ

Що таке serverless?

Модель обчислень, де cloud провайдер (AWS, Google, Azure, Cloudflare) управляє всією інфраструктурою, а ви пишете тільки функції (code). Ви не бачите та не управляєте серверами. Функції автоматично масштабуються, ви платите тільки за фактичне використання. Це контрастує з IaaS (Infrastructure as a Service), де ви керуєте віртуальними машинами, принаймні трохи.

Скільки економить serverless?

60-70% на інфраструктурі порівняно з виділеними серверами, особливо для додатків зі змінною навантаженням. Для 24/7 high-traffic додатків може бути дорожче. Наприклад, для API з 10 млн запитів/місяць: виділений сервер $100-300/міс, Lambda $20-50/міс. Але для always-on high-traffic сайту (1 млрд+ запитів) може бути дорожче. Важливо правильно оцінити ваш юз-кейс.

Що таке cold start?

Затримка (зазвичай 200-1000ms) при першому запуску неактивної функції Lambda. Це трапляється, коли функція не викликалася кілька хвилин. Причина: контейнер з runtime та кодом вивантажується, при наступному виклику потрібно завантажити та ініціалізувати все заново. Провайдери постійно оптимізують cold start, але він залишається трендом. Для time-sensitive операцій використовуйте provisioned concurrency або warm-up.

Чи підходить serverless для всіх проектів?

Ні. Ідеальний для: API, мікросервіси, обробка подій, cron jobs, webhooks. Не підходить для: long-running tasks (>15 min timeout на Lambda), always-on додатки (web server), робота з великою кількістю пам'яті, складні stateful операції. Для web сервера static content з Next.js на Vercel/Netlify — yes, це serverless. Для traditional web server — може бути і не рекомендується.

Як функції спілкуються між собою?

Через асинхронні канали: REST API виклики, message queues (SQS, RabbitMQ, Kafka), pub/sub системи (EventBridge, Pub/Sub), databases, cache (Redis). Прямі мережеві з'єднання між функціями ненадійні. Використовуйте message queues для надійності та retry logic. Це decouples функції та робить систему more resilient.

Як зберігати дані в serverless?

Використовуйте managed databases: DynamoDB, Firestore, MongoDB Atlas для NoSQL, Aurora RDS, Google Cloud SQL для SQL. Або cloud storage: S3, Google Cloud Storage, Azure Blob Storage для файлів. Не рекомендується зберігати state в самій функції (це йде при завершенні). Для сесії використовуйте Redis/Memcached. Для довгострокових даних використовуйте databases. Managed services — best practice, т.к. вони автоматично масштабуються.

Які provider вибрати: AWS, Google, Azure, Cloudflare?

AWS Lambda — найпопулярніший та mature, екосистема величезна, але складність висока. Google Cloud Functions — простий та інтегрований з Google сервісами, хорош для data processing. Azure Functions — хорош якщо вже використовуєте Microsoft stack. Cloudflare Workers — найкращий для edge computing та глобального розподілу, простий pricing. Для стартапа: Cloudflare Workers або Google Cloud Functions. Для enterprise: AWS Lambda. Для монолиту: Vercel/Netlify (Next.js).